近年、対話型AIエージェントという言葉をよく耳にするようになりました。生成AIの進化により、誰でも比較的簡単に会話できるAIを作れる時代になっています。しかし、実際の研究や社会実装の現場では、「AIと会話できる」だけではほとんど価値にならないことが分かってきました。

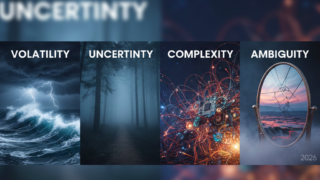

本当に重要なのは、そのAIエージェントがどの分野で、どの業務を対象にし、どの業界の課題を解こうとしているのかを、最初にきちんと定義することです。対話型AIエージェントの価値は、技術の新しさではなく、課題設定の明確さによって決まります。

分野が変わると、AIに求められる役割も変わる

対話型AIエージェントは、教育、医療、行政、企業活動など、さまざまな分野で活用が検討されています。ただし、分野が異なれば、AIに求められる振る舞いも大きく変わります。

教育分野では、学習者の理解を支援することが目的になります。ここでの課題は、答えをすぐに提示することではなく、学習者が自分で考える余地を残しながら、適切なヒントを与える対話設計です。間違った情報を断定的に伝えてしまうと、学習そのものを損なう危険があります。

医療や福祉の分野では、安全性と責任の所在が最優先されます。AIが診断や判断を行うことは難しく、多くの場合、問診内容の整理や説明補助といった、人の判断を支える役割に限定されます。この分野では、「AIができること」だけでなく、「あえてやらせないこと」を決めることが重要な課題定義になります。

業務の違いが、対話設計の方向性を決める

次に注目すべきなのが、対象とする業務です。同じ分野であっても、業務が違えば、対話型AIエージェントの設計思想は変わります。

問い合わせ対応や窓口業務では、同じ質問が繰り返されるという課題があります。この場合、単なるFAQの自動化ではなく、利用者の状況を少しずつ確認しながら、適切な案内につなげる対話が求められます。

一方、研究支援や企画業務では、明確な正解が存在しないことが多くあります。ここでのAIエージェントは、結論を出す存在ではなく、考えを整理したり、別の視点を提示したりする「思考の補助役」として設計されることが理想です。

現場作業を支援する業務では、専門用語や暗黙知が多く存在します。そのため、一般的な言葉だけを学習したAIでは役に立たず、現場特有のルールや判断基準をどう扱うかが課題になります。

業界ごとに異なる「許容されるAIの振る舞い」

対話型AIエージェントは、業界によって許される振る舞いの範囲が異なります。

製造業では、AIの誤案内が事故や品質問題につながる可能性があります。そのため、AIが自動で判断するのではなく、人が確認しやすい形で情報を整理・提示する設計が重視されます。

サービス業や小売業では、正確さだけでなく、利用者の体験そのものが価値になります。言葉遣いや応答のトーンなど、対話の質が課題となり、単なる情報提供では不十分になります。

教育や行政といった公共性の高い分野では、便利さよりも安心して使えることが求められます。説明責任や公平性をどう担保するかが、技術以上に重要な設計要素になります。

課題定義こそが、対話型AI研究の中核になる

対話型AIエージェントの構築において、最も問われるのは「どれだけ高度なAIを使っているか」ではありません。「どの課題を、どの立場で、どこまで支援するのか」を明確に説明できるかどうかです。

そのため、研究テーマや実証実験としては、分野、業務、業界の関係性を整理し、人とAIの役割分担を言語化すること自体が、大きな研究価値を持ちます。

対話型AIエージェントは、課題定義を通じて初めて、社会の中で意味を持つ存在になるのです。